Вид уравнения и предпосылки для регрессионного анализа

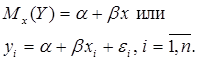

Парная линейная регрессия описывается уравнением

Для получения оценки параметров линейной функции регрессии взята выборка, состоящая из векторных переменных (xi, yi).

Оценкой записанной выше модели является уравнение ![]() где

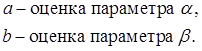

где

Классический подход к оцениванию параметров α и β основан на классическом (обычном или традиционном) методе наименьших квадратов (МНК).

Чтобы регрессионный анализ давал достоверные результаты, необходимо выполнить четыре условия Гаусса–Маркова:![]()

1. M(εi) = 0 – остатки имеют нулевое среднее для всех i = 1,…, n.

2. D(εi) = σ2 = const для всех i = 1,…, n – гомоскедастичность остатков, то есть их равноизменчивость.

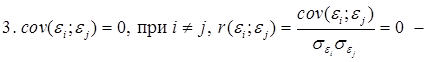

– отсутствие автокорреляции в остатках.

4. Объясняющая переменная X детерминирована, а объясняемая переменная Y – случайная величина и остатки не коррелируют с X: ![]()

Объясняющая переменная в том случае, когда она стоит в уравнении регрессии, может называться регрессором.

Наряду с этими четырьмя условиями Гаусса–Маркова применяют пятое условие: остатки должны быть распределены нормально; это условие необходимо для обеспечения правильного оценивания значимости уравнения регрессии и его параметров.

Наилучшие оценки называют BLUE–оценками (Best Linear Unbiased Estimators).

Они обладают следующими свойствами:

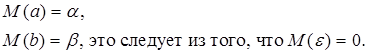

1. Это оценки несмещённые:

![]()

3. Оценки эффективны, то есть имеют наименьшие дисперсии среди всех возможных оценок.

Если нарушаются второе и/или третье условия Гаусса–Маркова, то оценки не теряют свойства 1 и 2, а свойство 3 (эффективность) теряют; дисперсии становятся смещёнными.